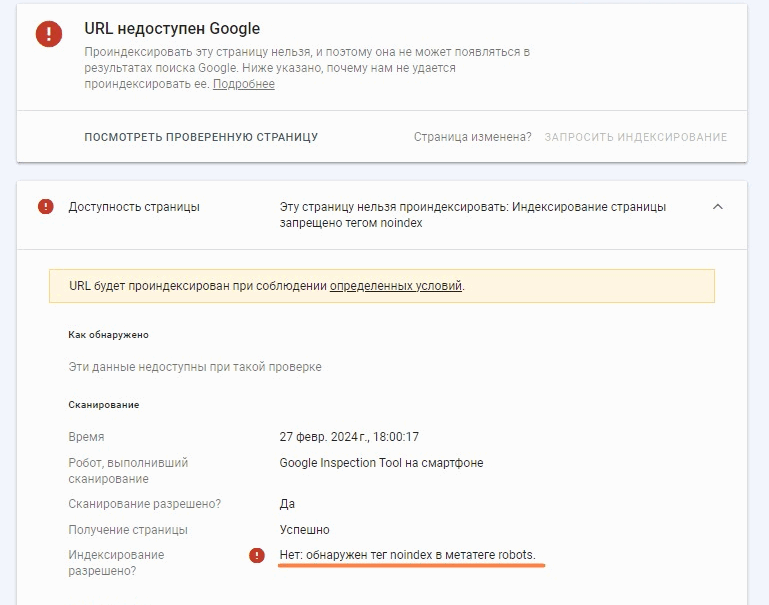

На днях столкнулся с ситуацией, когда у нового небольшого сайта оказалась проиндексирована только главная страница, а по времени должны быть все. Решил попробовать отправить URL на индексацию вручную через Google Search Console (GSC). В ответ получил, что URL запрещен к индексированию тегом noindex. Причем, не обратил внимание, что “тег noindex в метатеге robots” и пошел изучать robots.txt.

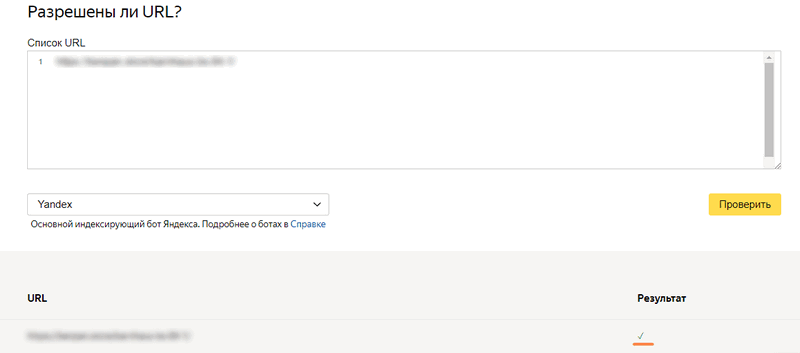

Анализ robots.txt в Яндекс.Вебмастере сказал ОК, страница разрешена для индексирования.

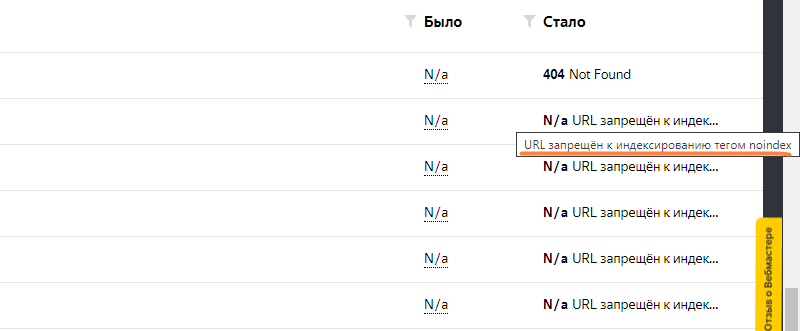

Статистика обхода говорила совсем обратное “URL запрещен к индексированию тегом noindex”.

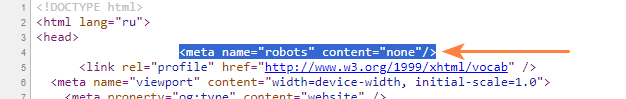

Тут пришло осознание, что речь идет о метатеге роботс, а не о файле. Открыл код страницы и увидел следующее:

None в этом случае соответствует “noindex, nofollow”, таким образом url страницы оказался запрещен к индексированию поисковыми системами. Скорее всего директиву поставили когда тестировали сайт, чтобы лишнее не попало в поиск, а потом забыли убрать.

Будьте внимательны, когда принимаете от разработчиков новые сайты.